Migliorare accuratezza, affidabilita' e interpretabilita' del calcolo distribuito

Un nuovo studio di Botond Szabo (del Dipartimento di Scienze delle Decisioni della Bocconi) pone le basi per metodi di calcolo distribuito più accurati, affidabili e interpretabili.

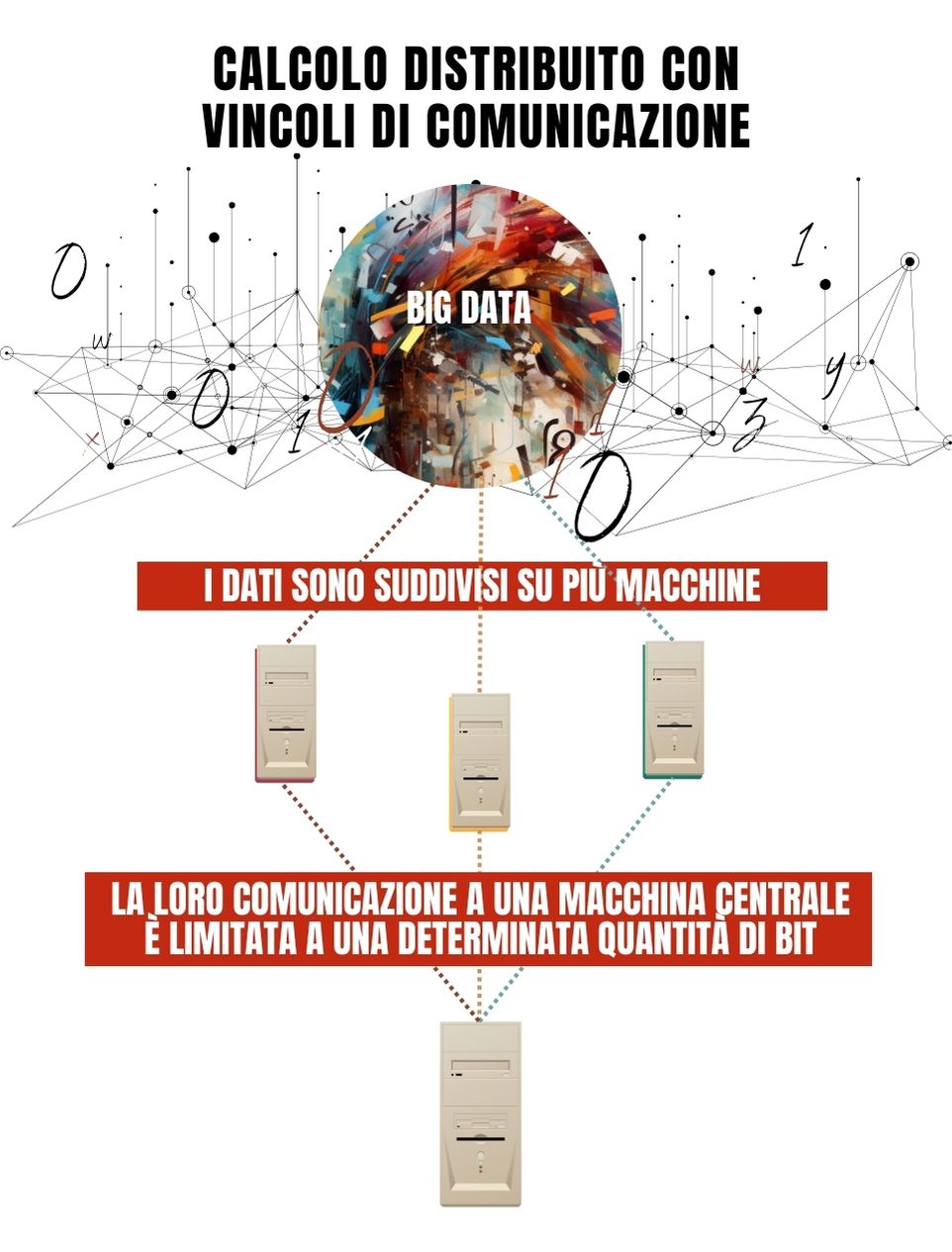

Nel mondo dei big data, quando c'è la necessità di stimare molti parametri in modelli statistici molto complessi che fanno uso di grandi quantità di informazioni disponibili, i tempi di calcolo diventano insostenibili anche con i supercomputer più veloci. Una delle strategie sviluppate per affrontare il problema è il calcolo distribuito (o parallelo). I dati (o i compiti, in alcuni casi) vengono suddivisi tra molte macchine e solo le informazioni di sintesi (i risultati dei calcoli) vengono inviate a una postazione centrale, ad esempio una stazione meteorologica, un osservatorio astronomico o un sistema di controllo del traffico. Questo metodo, inoltre, permette di contenere i problemi di privacy, poiché la maggior parte dei dati non deve essere spostata.

Infografica di Weiwei Chen

Infografica di Weiwei Chen

Tuttavia, anche la comunicazione di informazioni di sintesi tra i server può rivelarsi costosa e gli statistici hanno preso in prestito dagli ingegneri elettronici l'idea di limitare la larghezza di banda. "L'obiettivo," dice Szabo, "è ridurre al minimo il flusso di dati, perdendo il minor numero possibile di informazioni. Inoltre, il calcolo parallelo è spesso una procedura black-box, cioè una procedura che trasforma gli input in output in modi non ben compresi, e questo rende i risultati non completamente interpretabili, né affidabili. Sarebbe auspicabile trovare modelli matematici che diano un fondamento teorico a tali procedure." Botond Szabo è beneficiario di un grant ERC per studiare questi problemi.

Nel suo lavoro con Lasse Vuursteen (Delft University of Technology) e Harry van Zanten (Vrije Universiteit Amsterdam), Szabo elabora i test migliori per ridurre al minimo la perdita di informazioni in un contesto distribuito in cui i dati sono suddivisi su più macchine e la loro comunicazione a una macchina centrale è limitata a una determinata quantità di bit.

In statistica, un test è una procedura che permette di dire se un'ipotesi su un parametro è vera e quanto si può fare affidamento su questo risultato. In altre parole, quantifica l'incertezza. Quando leggiamo che un'ipotesi è "statisticamente non significativa", vuol dire che nei dati non è stata trovata alcuna prova a sostegno dell'ipotesi.

"I test che abbiamo sviluppato nel paper permettono di raggiungere la migliore precisione per una data quantità di informazioni trasmesse o la quantità minima di informazioni da trasmettere per raggiungere il livello di precisione necessario," spiega Szabo.

L'articolo è un lavoro fondamentale, che utilizza un caso matematico idealizzato, ma Szabo sta già lavorando su impostazioni più complesse. "Nel lungo termine," afferma, "potremmo sperare di ottenere algoritmi di comunicazione più efficienti, supportati da garanzie teoriche."

Botond Szabo, Lasse Vuursteen, Harry Van Zanten, "Optimal High-Dimensional and Nonparametric Distributed Testing Under Communication Constraints." Annals of Statistics, 51(3): 909-934 (June 2023). DOI: https://dx.doi.org/10.1214/23-AOS2269.